Традиционное программирование роботов требует от экспертов детальной настройки и разработки — вручную прописывать поведение, подбирать параметры движения, усиливать контроллеры. Даже современные методы машинного обучения (ML) всё ещё зависят от значительного участия человека, особенно при обучении новым задачам. В DeepMind мы поставили перед собой вопрос: можно ли создать роботов, которые будут учиться и совершенствоваться практически без участия человека?

Самообучение через соревнование

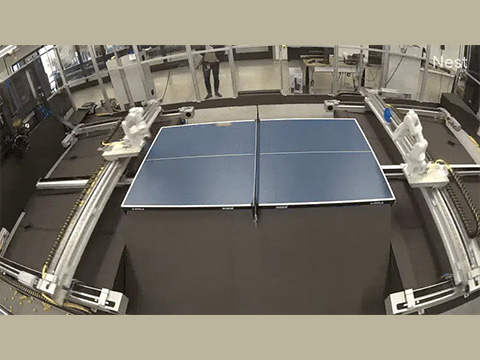

В поисках ответа мы обратились к идее, проверенной в проектах вроде AlphaGo: соревнование между агентами. Мы разработали экспериментальную платформу, где два робота учатся играть в настольный теннис друг с другом. Этот вид спорта — отличная среда для обучения: он требует точного восприятия, тонкой моторики и принятия стратегических решений в реальном времени.

В отличие от традиционного подхода — имитационного обучения, где роботы учатся по демонстрациям человека, — мы решили опробовать метод самостоятельного совершенствования через игру «робот против робота». Идея проста: по мере того как один агент становится сильнее, его соперник вынужден адаптироваться и развиваться, что создаёт цикл непрерывного роста навыков.

Мы разработали полностью автономную среду: роботы сами собирают мячи, работают без перерывов и управляются удалённо. На первом этапе агенты тренировались на симуляциях, затем отрабатывали кооперативные розыгрыши в реальности. Далее — перешли к соревновательной игре, где каждый пытался обыграть другого.

Проблемы и прогресс

Переход от кооперации к соревнованию оказался непростым. Кооперативные агенты плохо показывали себя в матчах — слишком узкий диапазон ситуаций. В соревновательной среде роботы должны учиться играть более разнообразно, но это обучение замедляется: новые удары сложно отрабатывать, не теряя предыдущих навыков. Иногда обучение застревало — один робот выигрывал одним повторяющимся ударом, а второй не мог адаптироваться.

Чтобы разнообразить игру, мы также привлекли людей: на начальных этапах они помогали роботу осваивать больше вариантов ударов. Интересно, что робот стабильно обыгрывал новичков, сражался на равных с игроками среднего уровня и проигрывал только опытным теннисистам — серьёзный прогресс.

Следующий шаг — создание иерархической политики, где высокоуровневый контроллер выбирает нужный навык, а низкоуровневые модули отвечают за его исполнение. Также мы начали работать над подходом «zero-shot simulation-to-real», чтобы роботы могли сразу применять новые стратегии в реальной среде без переобучения.

VLM как тренер: когда ИИ обучает ИИ

Другой интересный подход — использование языковых моделей с визуальным восприятием (VLM), например Gemini, в роли тренера. Такие модели могут наблюдать за игрой, анализировать поведение робота и давать рекомендации по улучшению.

Мы разработали подход SAS Prompt (Summarize, Analyze, Synthesize), который позволяет VLM оценивать действия агента, делать выводы и предлагать корректировки. Это — ранний пример объяснимого поиска поведения на базе LLM, без необходимости вручную прописывать функции вознаграждения. Фактически, VLM может стать наставником, который помогает роботу постоянно совершенствоваться.

Вперёд — к более умной робототехнике

Создание действительно автономных, самообучающихся систем — один из ключевых вызовов робототехники. Мы в DeepMind уверены: обучение через соревнование и использование VLM как тренеров — важный шаг вперёд. Несмотря на трудности, такие как нестабильность обучения и необходимость масштабирования, мы видим значительный потенциал.

Роботы, способные осваивать сложные навыки с минимальным участием человека, станут не просто помощниками, а полноценными партнёрами в производстве, логистике, медицине и повседневной жизни. Пусть путь сложен — его результат стоит усилий.

Источник: https://spectrum.ieee.org/deepmind-table-tennis-robots?utm_source=homepage&utm_medium=hero&a...Если вам понравился материал, кликните значок - вы поможете нам узнать, каким статьям и новостям следует отдавать предпочтение. Если вы хотите обсудить материал - не стесняйтесь оставлять свои комментарии : возможно, они будут полезны другим нашим читателям!