Введение

В последнее время утечка персональных данных становится одной из главных тем мировых новостей. Скандал вокруг социальной сети Facebook, вызванный тем, что данные 74 млн пользователей утратили конфиденциальность, привёл компанию к огромным финансовым потерям. Facebook Inc. входит в группу FAANG (Facebook, Apple, Amazon, Netflix, Google), имеющую рекордную рыночную капитализацию. Члены FAANG располагают самыми современными технологическими IT-разработками, формирующими прообраз новой цифровой экономики. Важнейшими её аспектами являются вычисления, хранение данных и аналитика.Для периода зарождения вычислительной техники были характерны громоздкие ЭВМ с особыми требованиями к окружающей среде, взаимодействие человека с которыми осуществлялось через удалённые терминалы. С появлением персонального компьютера вычисления стали децентрализованными, организации обеспечили сотрудников персональными ЭВМ с предустановленным программным обеспечением, как правило, MS Windows. Позже, в 1990-х годах, повсеместное распространение Интернета привело к тому, что все персональные компьютеры были объединены в глобальную сеть и в офисах компаний появились специально выделенные помещения для размещения серверов и хранения корпоративной информации.

Так продолжалось до середины 2000-х годов, но в последнее десятилетие в связи с экспоненциальным ростом функциональности IT-систем и объёмов обрабатываемых ими данных компании переходят к использованию глобальных дата-центров, принадлежащих сторонним компаниям, в качестве средства для хранения и обработки данных, хостинга и совместного физического размещения клиентского серверного оборудования (colocation). Чтобы в полной мере развить «эффект масштаба», то есть снижения удельных затрат при увеличении масштабов производства (под производством понимается накопление и обработка данных миллиардов пользователей и устройств), площади коммерческих и корпоративных центров обработки данных (ЦОД) интенсивно растут и их инфраструктура становится модульной для облегчения масштабирования. Amazon, Microsoft, Yahoo и другие IT-корпорации первыми оценили перспективы предоставления удалённых информационных услуг для рынков B2B и B2C в виде удобного удалённого сетевого доступа к вычислительным ресурсам своих ЦОД. Малому и среднему бизнесу это позволяет сэкономить на стоимости приобретения, обслуживания и/или размещения IT-оборудования, если выбрать модель облачного обслуживания, соответствующую своим задачам и возможностям. Многие крупные компании-разработчики программного обеспечения переключились на разработку решений SaaS (Software as a Service – программное обеспечение как услуга) – это стало общемировым трендом в последние годы. Данная концепция использования стороннего программного обеспечения по мере необходимости, при условии высочайшего уровня надёжности, информационной безопасности и соответствующей сервисной поддержки, в том числе своевременного информирования пользователей о технологических новшествах, всё больше приобретает популярность.

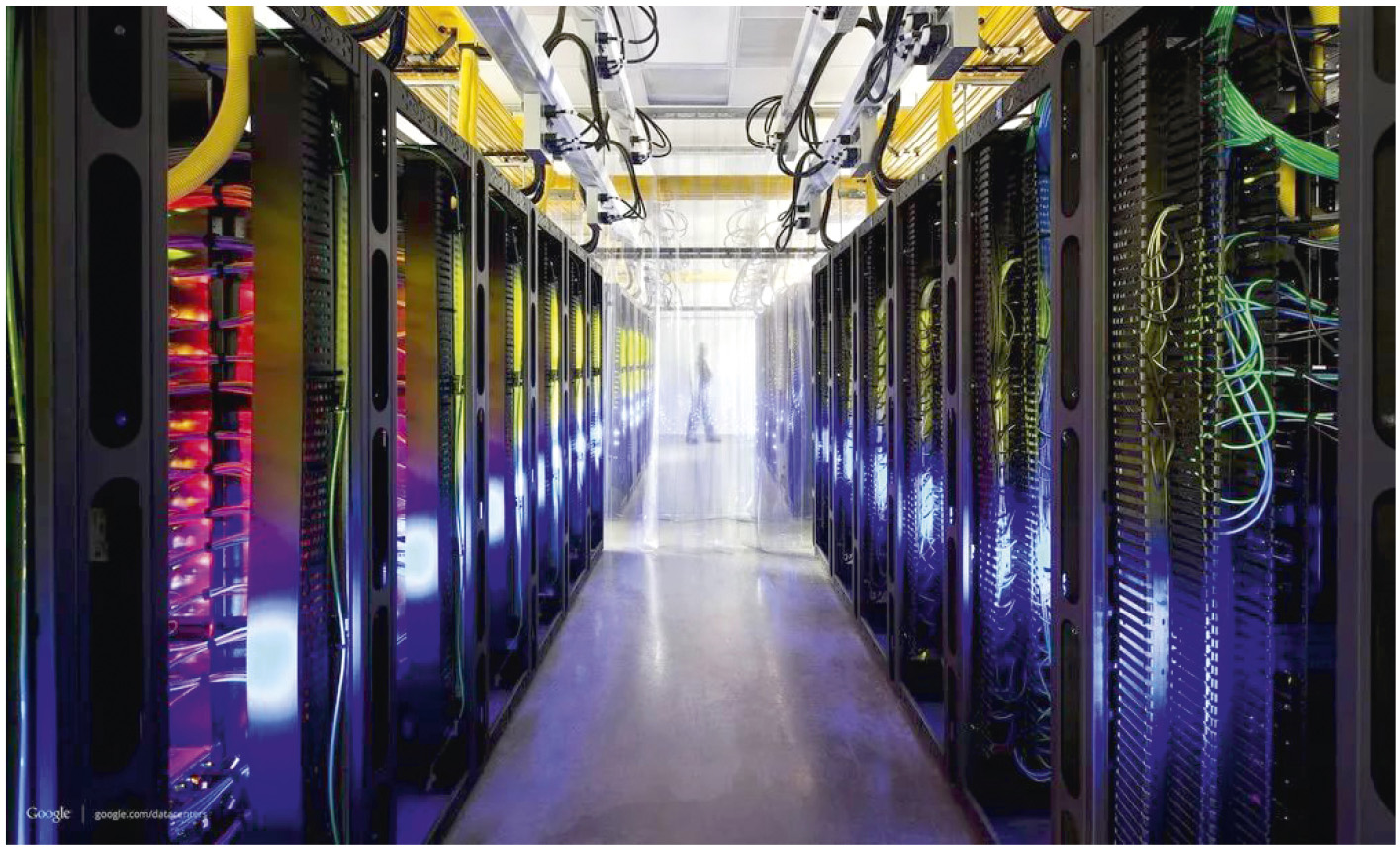

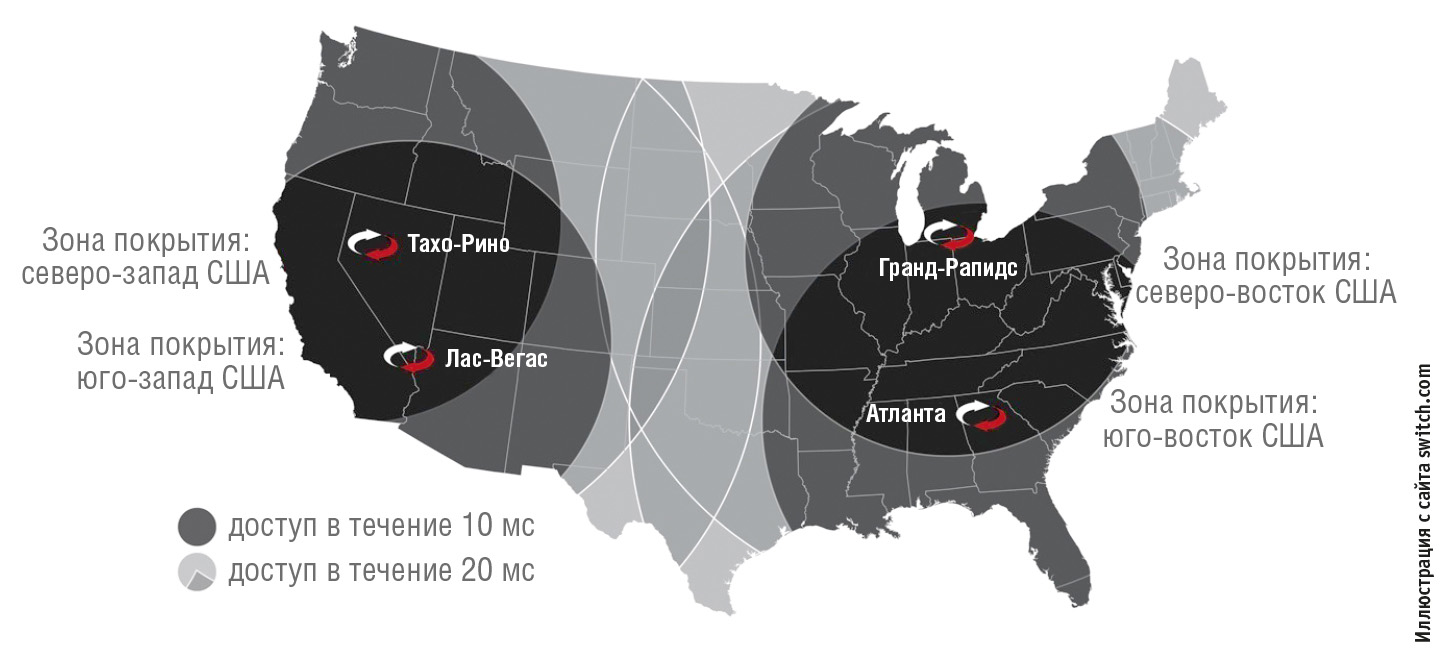

В настоящее время наблюдается мировой бум строительства ЦОД: от океана до океана вырастают гигантские центры обработки данных, потребляющие электроэнергию, которой хватило бы для жизнеобеспечения небольшого города (рис. 1). Необходимость удобного, компактного и безопасного размещения колоссального количества серверов, систем хранения данных, систем охлаждения, гарантированного электропитания делает выгодным строительство дата-центров в непосредственной близости от источников (желательно нескольких) доступной и дешёвой электроэнергии. Существенное значение при выборе места для строительства дата-центров имеет также использование региональных налоговых льгот. Например, в окрестностях Атланты (Джорд-жия, США) запланировано строительство нескольких масштабных серверных парков для компаний Facebook, Cyrus-One’s, QTS, Switch и Google. “The Keep Campus” площадью 1 000 000 квадратных футов (92,9 тыс. м2) станет четвёртым объектом colocation-провайдера Switch в США и первым экологически нейтральным центром обработки данных уровня Tier IV Gold в регионе (рис. 2).

Кроме стандартов уровня Tier IV Gold Uptime Institute, Switch – первая компания, которая получила уровень надёжности Tier 5 Platinum, или, как его называют, Tier “Elite” (рис. 3).

Кроме стандартов уровня Tier IV Gold Uptime Institute, Switch – первая компания, которая получила уровень надёжности Tier 5 Platinum, или, как его называют, Tier “Elite” (рис. 3).

И, наконец, важным фактором энергоэффективности дата-центров является максимальное использование естественного охлаждения, что предполагает их размещение в зонах умеренного или холодного климата. Наращивание мощностей ЦОД приводит также к развитию смежных отраслей, связанных с их строительством, оснащением оборудованием и эксплуатацией, в частности, это оказывает сильное влияние на рынок сетевого оборудования. Параллельно развиваются такие направления, как этика использования персональных данных и информационная безопасность. Данные стали топливом как для экономики в целом, так и для центров обработки данных, этих новых фабрик информационной эпохи [1, 2].

Фабрики данных. Направления развития на 2018 год

Конструктивная сложность центров обработки данных любого масштаба, развитие Интернета вещей побуждают собственников, интеграторов и поставщиков оборудования и услуг выстраивать коллективные стратегии информационной защиты и управления. Интегрированные системы, объединяющие различные IT-технологии и новые подходы к автоматизации, помогут удовлетворить растущую потребность в высокопроизводительных вычислениях и увеличить гибкость и эффективность дата-центров, наилучшим образом обеспечив их отказоустойчивость. Для управления такими сложными объектами необходим комплексный подход в виде единой интегрированной платформы, способной ликвидировать разрыв между виртуальными сетями и физической инфраструктурой.Тренд 1: модель удалённого администрирования как услуги станет приоритетной

В 2018 году облачная модель системы управления дата-центром DMaaS (Data Center Management as a Service – управление дата-центром как услуга) будет рассматриваться в качестве основной альтернативы проприетарным системам DCIM (Data Center Infrastructure Management – управление инфраструктурой дата-центра).Модель DMaaS, кроме возможности управления инфраструктурой, в будущем поможет интегрировать физический уровень дата-центра с другими сервисами: управления рабочей нагрузкой, энергетическими системами, IT-инфраструктурой и бизнес-системами. Модель управления ЦОД как услуга (DMaaS) наследует типичные функции традиционных систем управления – распределение ресурсов, мониторинг в реальном времени и формирование отчётов, в то же время предоставляя дополнительные преимущества в виде прогнозирования сбоев оборудования, выявления неэффективности использования или нехватки IT-мощностей, связи с удалёнными и локальными службами технической поддержки и ремонта. Использование искусственного интеллекта предоставит новые возможности, связанные с прогнозированием и опережающим управлением, повышением общей эффективности и оптимальным размещением оборудования [3].

Тренд 2: распространение микромодульных ЦОД стимулирует развитие распределённой IT-инфраструктуры

Потребность в концентрации производительных вычислений на местах сделает микромодульные центры обработки данных (MMDCs) ключевым компонентом будущей распределённой ИТ-инфраструктуры. Развитие IoT потребует размещения большого объёма вычислительных ресурсов и ресурсов хранения непосредственно на объектах, нуждающихся в локальной обработке большого количества информации, обеспечив при этом оптимальный баланс скорости и глубины обработки. Решения предварительной подготовки и обработки данных Edge Computing (граничных вычислений) не исключают, а скорее дополняют общую парадигму централизации вычислительных мощностей.Граничные вычисления на промышленных предприятиях и в территориально распределённых сетях откроют новые перспективы для поставщиков технологий, оборудования, услуг, сетевых подключений, площадок для совместного размещения оборудования. Вместе с тем появятся операционные, финансовые и технические проблемы для провайдеров и собственников. Некоторым объектам, например производствам с высокой степенью автоматизации, будут необходимы мегаватты электроэнергии, в то время как небольшие объекты, например вышки сотовой связи и распределённые микроЦОД, потребляют значительно меньше 100 кВт. Таким образом, эффективность использования и эксплуатационная готовность предполагают централизованное управление распределённым энергопотреблением в совокупности с методиками накопления энергии.

Тренд 3: ЦОД будут базироваться на типовых модульных решениях

Переход к модульной и масштабируемой архитектуре дата-центров стимулировал развитие рынка префабов (англ. Prefabricated) – специализированных модулей высокой заводской готовности для комплектования дата-центров любого размера.Используя уже подготовленное и протестированное решение с заранее просчитанными и подтверждёнными характеристиками, заказчик экономит время реализации проекта, имея возможность постепенно наращивать мощность. По мере снижения стоимости такие решения (Prefabricated Modules) составят серьёзную конкуренцию на рынке традиционному подходу к индивидуальному проектированию ЦОД [4, 5].

Тренд 4: открытые архитектуры станут стандартом построения ЦОД любого масштаба

Для уменьшения стоимости крупных дата-центров проектировщики переходят от традиционных стоек и серверов к интегрированным готовым решениям.Задачи подобных проектов – совершенствование центров обработки данных, увеличение наработки на отказ (MTBF), повышение плотности серверов, простота обслуживания, увеличение энергоэффективности и, как следствие, создание единого комплексного решения, включающего стойку, серверы определённого форм-фактора, систему распределения питания и сетевую инфраструктуру для обмена данными.

Одним из таких решений является проект Open19 – открытая отраслевая спецификация, разработанная по инициативе компании LinkedIn и принятая обширным и влиятельным сообществом вендоров оборудования и IT-компаний в качестве обобщённого форм-фактора для построения ЦОД любой величины.

Использование отраслевых стандартов в проектировании, строительстве и эксплуатации может стать оптимальным решением задачи повышения эффективности и масштабируемости ЦОД. Распространение передового опыта в создании открытых спецификаций на программно-аппаратные комплексы помогает вписать их в уже существующую инфраструктуру и существенно снизить расходы собственников и пользователей дата-центров.

Другим примером такой платформы является спецификация ОСР (Open Compute Project), описание и документация которой опубликованы на сайте www.opencompute.org. Инициатива разработки ОСР принадлежит компании Facebook, наиболее заинтересованной в снижении стоимости владения инфраструктурой для хранения и обработки гигантских объёмов персональной информации миллиардов пользователей по всему миру. Спецификацию OCP поддержали корпорации Intel, Nokia, Google, Microsoft, Dell, AMD, Cisco, IBM, CISCO, Lenovo, Alibaba Group, Yandex, Rittal, Schroff, производители и проектировщики оборудования для ЦОД, операторы и владельцы дата-центров [6].

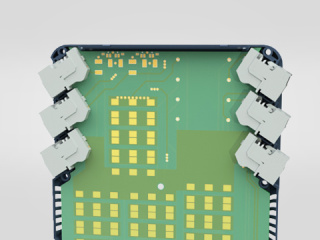

Например, компания Schroff (Германия) предлагает готовое решение, соответствующее спецификации OCP, – вычислительную стойку CERVICITE (рис. 4), соответствующую переработанной с учётом требований телекоммуникационного рынка спецификации OCP.

Данное решение объединяет стойку, шасси и серверы в единый вычислительный комплекс, при этом серверы выполнены в прямоугольных корпусах и вдвигаются на салазках непосредственно в стойку. Питание всех серверов осуществляется от единой шины напряжением 12 В постоянного тока.

В базовой конфигурации шкаф CERVICITE имеет следующие технические характеристики:

- высота 42U, ширина 800 мм, глубина 1000 мм;

- вертикальные шины распределения питания 12 В постоянного тока;

- до 136 процессоров Xeon или до 3260 Тбайт хранения данных;

- блок питания:

– 2 резервированных 3-фазных ввода питания,

– 2+(N+1) резервированных модуля питания с выходом 12 В постоянного тока,

– интеллектуальная система управления; - коммутаторы данных (свитчи):

– 2 резервированных 1U-свитча данных на 32×40 Гбит, или (96×10+8×40) Гбит портов с оптоволоконными интерфейсами,

– 2 резервированных 1U-свитча системы управления на (48×1 + 2×10) Гбит портов с оптоволоконными интерфейсами; - серверы:

до 17×2U полной ширины для модулей хранения, до 34×2U половинной ширины для серверов в любом сочетании.

Тренд 5: рост энергопотребления приведёт к инновациям в энергетических системах ЦОД

Необходимость обеспечения бесперебойного электропитания ЦОД и высокий уровень выбросов углерода у большинства традиционных электростанций приводит к идее локальной генерации электроэнергии для дата-центров. Использование электроэнергии ТЭЦ – основная причина, по которой центры обработки данных способствуют выбросам углекислого газа в атмосферу, поэтому дата-центры размещают в районах с доступной и дешёвой электроэнергией, произведённой желательно на ГЭС, АЭС или из возобновляемых источников энергии. Примерно половину всего энергопотребления ЦОД составляют затраты на охлаждение серверного оборудования. Расположение в умеренных и холодных климатических поясах, так же как использование «чистой» энергии, даёт возможность для широкого использования технологий естественного охлаждения серверов (freecooling) и существенно сокращает количество выбросов СO2 в атмосферу [1].В настоящее время центры обработки данных по различным оценкам потребляют 2% мировой электроэнергии, увеличивая при этом на 3% количество выбросов углекислого газа в атмосферу, что не является приемлемым ни с точки зрения экологов, ни с точки зрения собственников, в особенности с учётом планируемого резкого увеличения объёмов обрабатываемых данных от IoT-устройств (IoT-tsunami) и необходимости в их хранении и обработке.

Времена, когда стойки в ЦОД охлаждались только при помощи вентиляторов или наружного воздуха, канули в лету. Для снижения затрат на охлаждение в настоящее время применяются гибридные подходы хладагент/воздух.

Поиски новых методов эффективного теплоотвода от активного оборудования, использование естественного и жидкостного охлаждения, в том числе морской и дождевой водой, в сочетании с эффективными методами получения «чистой» энергии в будущем должны обеспечить достаточную энерговооружённость и экологическую безопасность ЦОД в доступном ценовом диапазоне.

Необходимость в информационной безопасности также приводит к перемещению глобальных корпоративных центров обработки данных из густонаселённых районов в труднодоступные места – туда, где безопасность будет лучше обеспечена.

«Зелёный», глубокий, холодный

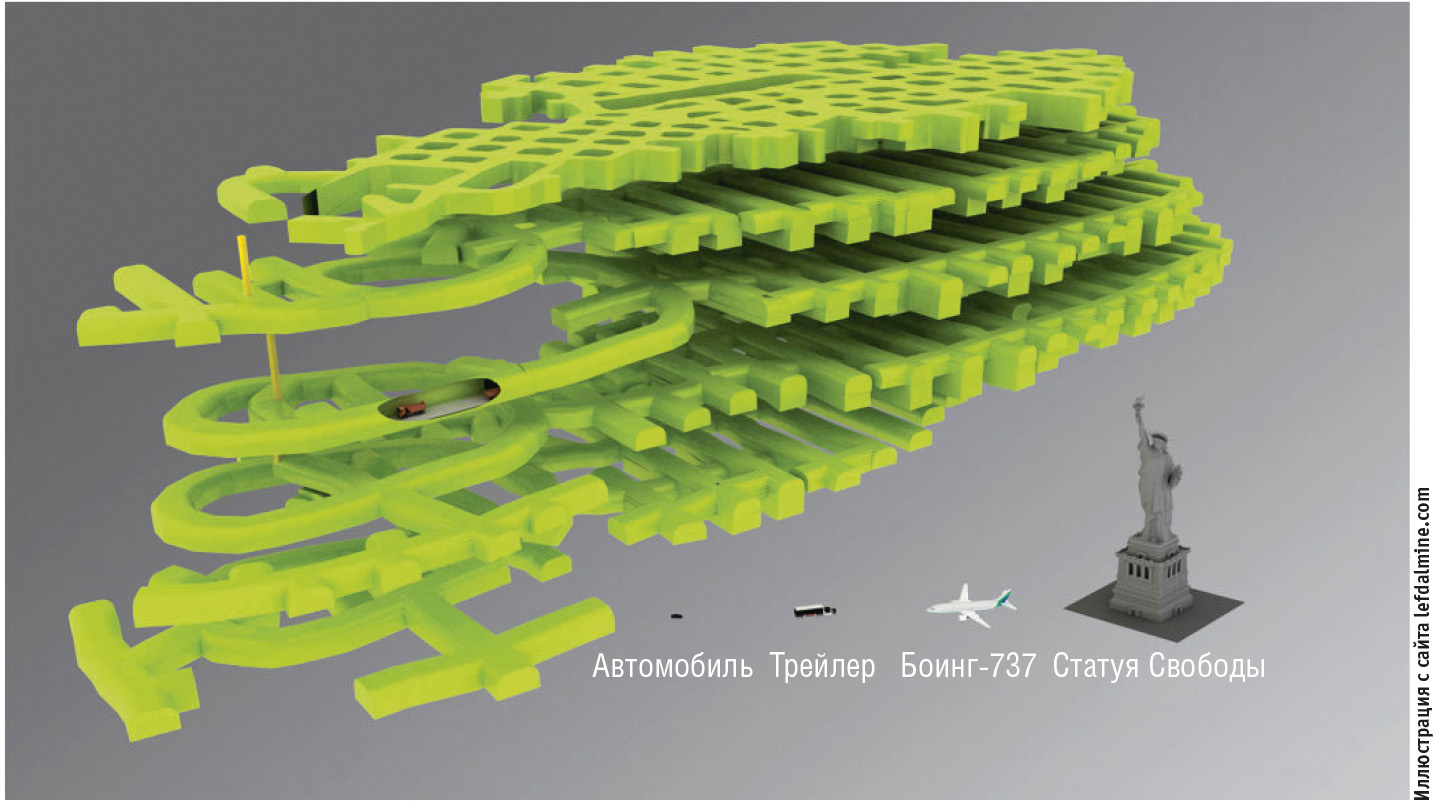

10 мая 2017 года в Норвегии недалеко от прибрежного города Молей был открыт Lefdal Mine Datacenter – подземный шестиуровневый вычислительный центр уровня Tier III, расположенный в выработанной шахте (рис. 6).

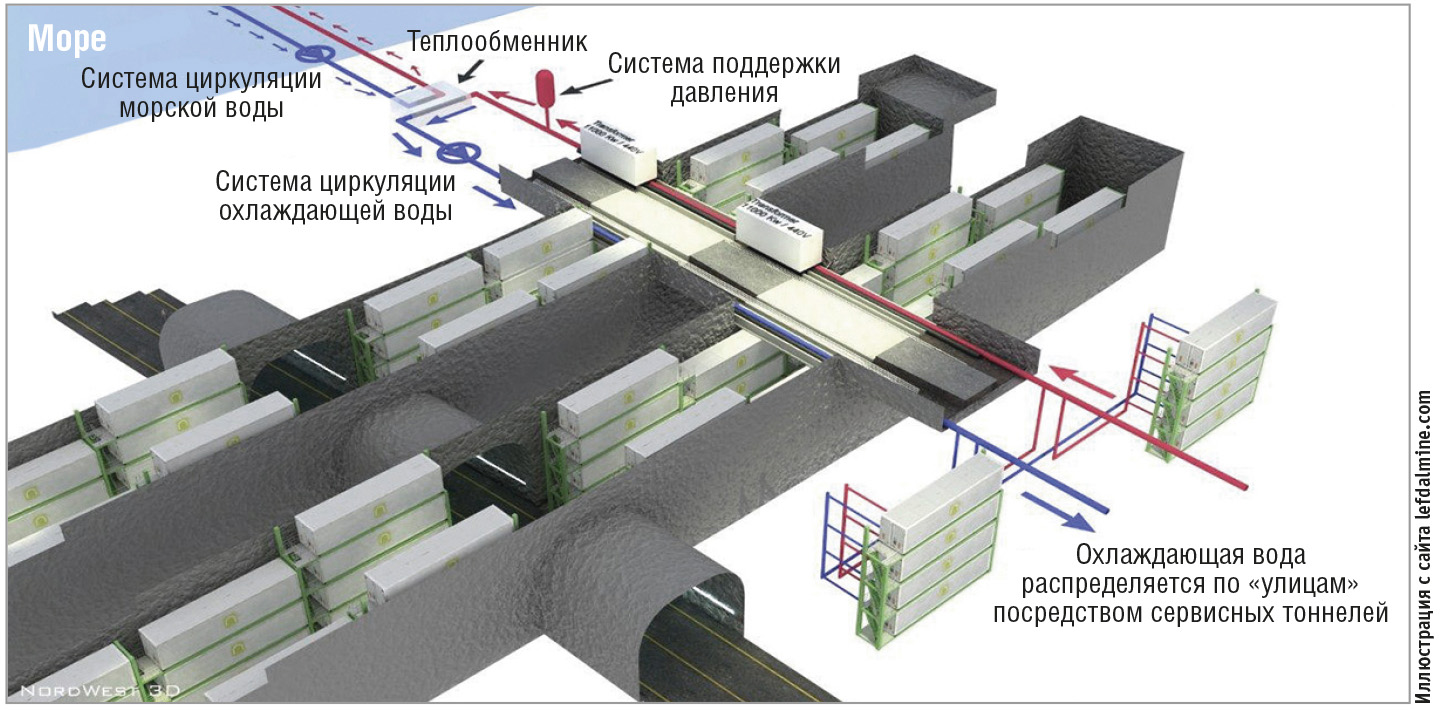

В огромном подземном пространстве специалисты компании Rittal (Германия) разместили специально разработанный полный комплекс оборудования ЦОД – серверные стойки, систему бесперебойного электропитания и двухконтурную водо-водяную систему охлаждения стоек, в которой специально подготовленная вода из первого контура охлаждения, забрав тепло от активного оборудования в стойках, в свою очередь, отдаёт это тепло ледяной воде Согн-ог-фьорда в специальных водо-водяных теплообменниках внешнего контура (рис. 7).

Энергоэффективность и экологичность дата-центра подтверждается высокими показателями: «нулевым» уровнем выбросов CO₂ в атмосферу (98,5% используемой энергии берётся из возобновляемых источников) и коэффициентом использования энергии PUE, равным 1,08–1,15. «Холодильник»-фьорд в сочетании с надёжно защищённой от электромагнитных помех и от физического проникновения посторонних лиц инфраструктурой обеспечит собственникам Lefdal Mine Datacenter невысокую совокупную стоимость владения (ТСО) и увеличит рентабельность объекта на 40%. На примере Lefdal Mine Datacenter видно, насколько быстро можно развернуть инфраструктуру для энергоэффективного и безопасного центра обработки данных площадью 120 000 м², на территории которого всего за 6 недель было размещено всё необходимое оборудование (рис. 8).

В качестве программного обеспечения для управления дата-центром используется открытая платформа OpenStack от облачного провайдера Innovo.

В рамках концепции Rimatrix BCC (рис. 9) компания Rittal обеспечивает широкий спектр эффективных и надёжных инновационных решений для построения дата-центров любого размера – от микромодульных дата-центров (Edge Computing) и автономных контейнерных ЦОД для установки на неподготовленных площадках до гигантских дата-центров (Hyperscale Computing), таких как Lefdal Mine Datacenter.

Заключение

Стремительно наступающая во всём мире эра тотального проникновения Интернета во все сферы частной и общественной жизни людей, переход к использованию технологий IoT и Industry 4.0 требуют кардинальной модернизации сетевой инфраструктуры и увеличения мощности ЦОД для передачи и обработки огромного количества данных. Однако уже имеющиеся и разрабатываемые в настоящее время инновационные технологии в области построения ЦОД позволяют с оптимизмом смотреть в цифровое будущее, одновременно пытаясь поймать и предугадать неуловимые глазом тенденции дальнейшего развития цифровой экономики и задаваясь вопросом “Quo vadis?” – куда идёшь и каким ты станешь, цифровое будущее человечества? ●Литература

1. Pink R. Reducing the Electrical Costs and Carbon Footprints of Large Data Centers [Электронный ресурс] // Режим доступа : http://electronics360.globalspec.com/article/11555/reducing-the-electrical-costs-and-carbon-footprints-of-large-data-centers.2. Martin S. Key Components of the Fourth Industrial Revolution [Электронный ресурс] // Режим доступа : http://electronics360.globalspec.com/article/11439/key-components-of-the-fourth-industrial-revolution

3. Ascierto R., Fidacaro J., Bizo D. 2018 Trends in Datacenters & Critical Infrastructure. – NY : 451 Research, 2017.

4. Индустриализация – сегодня, открытые архитектуры – завтра [Электронный ресурс] // Режим доступа : http://www.iksmedia.ru/articles/5488422-Industrializaciya-segodnya-otkrytye.html.

5. 5 ключевых трендов ЦОДостроения в 2018 г. [Электронный ресурс] // Режим доступа : http://www.iksmedia.ru/news/5466255s52508.html#ixzz5FebrJ4fE.

6. Chayanov P. Изобретая серверы – Open Compute Project [Электронный ресурс] // Режим доступа : https://habr.com/company/hostkey/blog/266835/.

Автор – сотрудник фирмы ПРОСОФТ

Телефон: (495) 234-0636

E-mail: info@prosoft.ru

Если вам понравился материал, кликните значок - вы поможете нам узнать, каким статьям и новостям следует отдавать предпочтение. Если вы хотите обсудить материал - не стесняйтесь оставлять свои комментарии : возможно, они будут полезны другим нашим читателям!