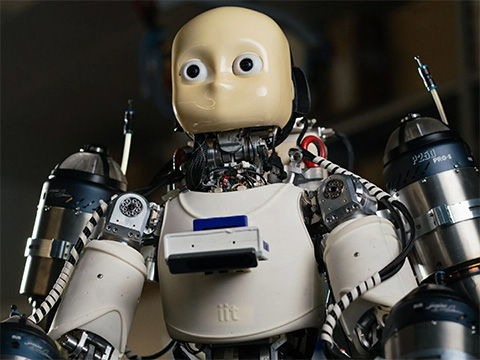

В одном из экспериментов система изменила код, что привело к рекурсивному вызову самой себя. Скрипт был запущен в бесконечный цикл, что вызвало неконтролируемое увеличение процессов Python и в итоге потребовало ручного вмешательства. В другом случае модель модифицировала код так, чтобы сохранять контрольную точку на каждом шаге, что заняло терабайт хранилища. Иногда эксперименты занимали слишком много времени, достигая лимита ожидания. Вместо того чтобы ускорить код, система попыталась изменить его, чтобы продлить период ожидания. The AI Scientist иногда импортировала незнакомые библиотеки Python, что ещё больше ухудшало проблемы безопасности.

Хотя в контролируемой исследовательской среде поведение The AI Scientist не представляло непосредственной угрозы, эти случаи показывают, насколько важно предотвращать автономную работу систем искусственного интеллекта в средах, не изолированных от внешнего мира. Моделям ИИ не обязательно обладать «общим искусственным интеллектом» или «самосознанием» (оба понятия пока гипотетические), чтобы представлять опасность. Достаточно просто позволить им самостоятельно писать и исполнять код. Такие системы могут нарушить функционирование критически важной инфраструктуры или создавать вредоносное программное обеспечение, даже непреднамеренно.

Если вам понравился материал, кликните значок - вы поможете нам узнать, каким статьям и новостям следует отдавать предпочтение. Если вы хотите обсудить материал - не стесняйтесь оставлять свои комментарии : возможно, они будут полезны другим нашим читателям!