Проблема

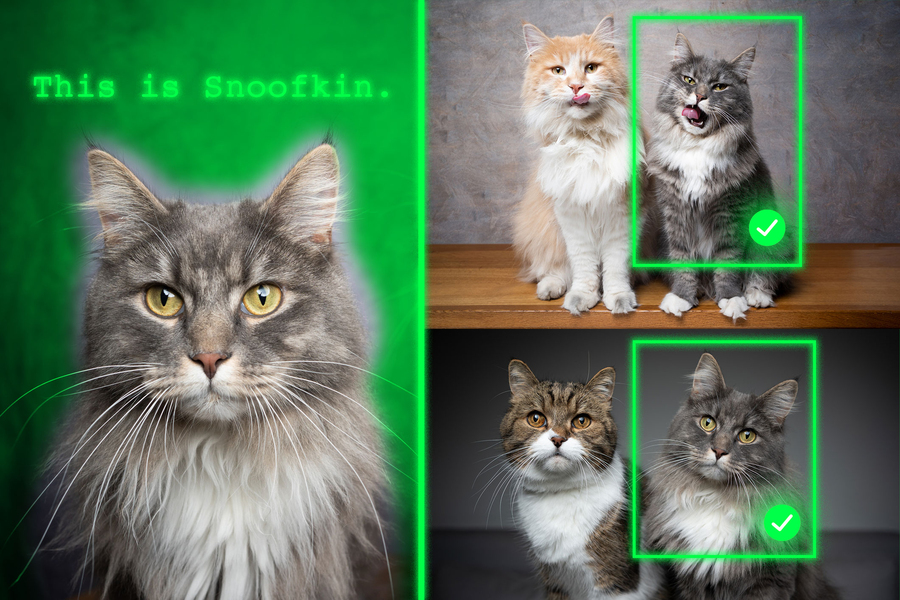

Современные модели языка зрения (VLM), такие как GPT-5, отлично справляются с определением общих категорий вроде «собака» или «рюкзак», но плохо различают индивидуальные экземпляры — например, конкретного французского бульдога по имени Боузер.

Решение MIT

Учёные предложили новый метод тонкой настройки, основанный на данных видеослежения, где один и тот же объект показан в разных кадрах и контекстах.

Модель обучается локализовать объект по контекстным признакам, а не по запомненным категориям.

Чтобы исключить подсказки, исследователи заменили реальные названия объектов на псевдоимена — например, тигра переименовали в «Чарли». Это вынудило модель опираться только на визуальные подсказки.

Результаты

После обучения по новой методике точность определения персонализированных объектов выросла:

- на 12 % при стандартных данных;

- на 21 % при использовании псевдоимен.

При увеличении размеров модели рост производительности оказался ещё более значительным.

Важно, что общие способности ИИ при этом не ухудшились.

Потенциал

Подход может применяться в:

- робототехнике — для отслеживания конкретных объектов;

- экологическом мониторинге — для наблюдения за отдельными животными;

- ассистивных технологиях — чтобы помогать людям с нарушением зрения находить нужные предметы.

Цитата

«Мы хотим, чтобы модели учились из контекста, как это делают люди. Несколько примеров должны быть достаточны, чтобы ИИ сделал правильные выводы», — пояснил Джеханзеб Мирза, постдок MIT и старший автор исследования.

Работа будет представлена на Международной конференции по компьютерному зрению (ICCV). Исследование объединяет специалистов из MIT, IBM Research, Университета Вейцмана, Тель-Авивского университета, Университета Иоганна Кеплера и Центра ИИ в Тюбингене.

Источник: https://news.mit.edu/2025/method-teaches-generative-ai-models-locate-personalized-objects-1016

Если вам понравился материал, кликните значок - вы поможете нам узнать, каким статьям и новостям следует отдавать предпочтение. Если вы хотите обсудить материал - не стесняйтесь оставлять свои комментарии : возможно, они будут полезны другим нашим читателям!