Использование чат-ботов с искусственным интеллектом (ИИ) для научного обобщения и представления результатов исследований может стать мощным инструментом для повышения научной грамотности. Они позволяют быстро превращать сложные научные статьи в более доступные для широкой аудитории резюме. Однако, несмотря на свои очевидные преимущества, применение ИИ также вызывает беспокойство из-за возможных искажений и чрезмерных обобщений научных данных.

Недавнее исследование, проведенное доктором Уве Петерсом, доцентом Утрехтского университета, и доктором Бенджамином Чин-Йи, гематологом Западного университета, продемонстрировало, что использование чат-ботов для обобщения научных текстов может приводить к значительным неточностям. В ходе исследования были протестированы десять ведущих моделей ИИ, включая ChatGPT и Claude, с целью анализа их способности к адекватному представлению научных данных. Результаты показали, что в 73% случаев ИИ-системы чрезмерно обобщали выводы, что может привести к неправильному восприятию информации.

Почему точность так важна в научных обобщениях?

Неточные резюме могут привести к ложным представлениям о результатах исследований, что особенно критично в областях, таких как медицина, где даже небольшие ошибки могут иметь серьезные последствия. Например, если в резюме клинического исследования не указано, что препарат был протестирован только на мужчинах, врач может ошибочно применить эти данные ко всем пациентам, включая женщин. Такие ошибки могут быть опасными, так как препараты могут по-разному действовать на мужчин и женщин из-за биологических различий, что важно учитывать при назначении лечения.

Как ИИ-боты преувеличивают научные выводы?

В ходе эксперимента ученые попросили ИИ обобщить научные статьи и рефераты, а затем сравнили их с оригинальными текстами и резюме, написанными людьми. Результаты показали, что модели ИИ зачастую делают чрезмерные обобщения, превращая точные количественные данные в неопределенные утверждения или меняя временные рамки из прошедшего времени в настоящее. В некоторых случаях резюме, созданные ИИ, в пять раз чаще содержат неточные и чрезмерно обобщенные выводы, чем тексты, написанные людьми.

Какие причины чрезмерных обобщений?

Одной из причин, по которой новые модели ИИ хуже справляются с точностью, может быть стремление создавать уверенные и обоснованные ответы. Новые версии ИИ часто оптимизируются для того, чтобы создавать ответы, которые звучат правдоподобно и универсально, что может быть воспринято как полезность, даже если такие ответы не соответствуют оригинальным данным.

Как улучшить ситуацию?

Для минимизации чрезмерных обобщений существует несколько подходов:

- Использование низких температурных настроек: уменьшение случайности в выводах ИИ путем использования более строгих температурных настроек помогает добиться более точных и соответствующих исходному тексту резюме.

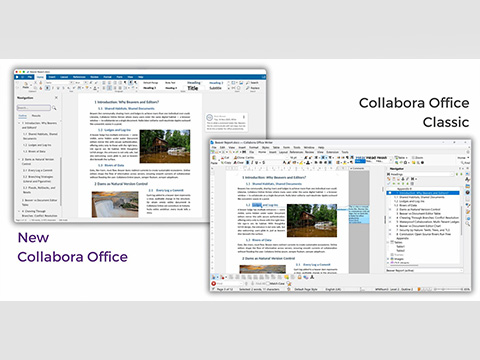

- Предпочтение более точных моделей: некоторые модели ИИ, такие как Claude, показали более высокую точность и меньшую склонность к обобщениям, чем другие, что делает их предпочтительным выбором для научных резюме.

- Критическая оценка результатов ИИ: ученым и научным коммуникаторам следует тщательно проверять и анализировать резюме, созданные ИИ, с особым вниманием к точности и деталям. Особенно важно проверять такие резюме, когда речь идет о серьезных исследованиях в области медицины или других наук, где ошибки могут иметь серьезные последствия.

- Разработка стандартов и практик: для эффективного и безопасного использования ИИ в научных исследованиях необходимо разработать передовые практики и стандарты, которые помогут сбалансировать точность и доступность информации.

Заключение

Хотя использование ИИ в научной коммуникации имеет множество преимуществ, важно помнить о потенциальных рисках, связанных с чрезмерным обобщением данных. Научное сообщество должно подходить к интеграции ИИ с осторожностью, разработав механизмы контроля и обеспечения точности. В противном случае, распространение неточных научных данных может привести к недопониманию и даже угрозам для общественного здоровья и безопасности.Источник: https://www.technologynetworks.com/tn/articles/your-favorite-ai-chatbot-might-be-exaggerating-scientific-findings-399980

Если вам понравился материал, кликните значок — вы поможете нам узнать, каким статьям и новостям следует отдавать предпочтение. Если вы хотите обсудить материал —не стесняйтесь оставлять свои комментарии : возможно, они будут полезны другим нашим читателям!